Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

Tags

- GCN

- 데이터입수

- 도커 레이어

- GIS

- 좌표거리

- 알고리즘

- docker

- 지하철역좌표

- 3d

- 패치분할

- 도커

- 귀여운고래

- Set

- 이미지빌드

- STL

- 동명이인찾기

- python최단거리

- geopandas

- pyvista

- 폴더조사

- graph

- osmnx

- 컨테이너

- geojson

- 3d데이터

- Python

- 파이썬

- GNN

- 그리드분할

- MESH

Archives

- Today

- Total

이것저것 기록

[graph] graphSAGE의 embedding generation algorithm에 대한 기록 본문

Data Science/ML & DL

[graph] graphSAGE의 embedding generation algorithm에 대한 기록

anweh 2021. 1. 5. 15:38

"...we learn how to aggregate feature information from a node's local neighborhood (e.g. the degrees or text attributes of enarby nodes)."

1. Before graphSAGE...

- 기존의 그래프 노드 임베딩 방법론에는 factorization-based embedding approach, supervised learning over graphs, GCN이 있었다.

- Factorization-based embedding approach: Learn low-dimensional embeddings using random walk. statistics and matrix factorization-based learning objectives.

- Supervised learning over graphs: includes a wide variety of kernel-based approaches, where feature vectors for graphs are derived from various graph kernels.

- GCN

2. graphSAGE

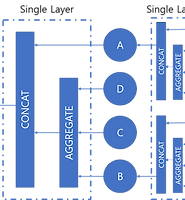

- 어떠한 노드의 feature를 만들기 위해 주변 노드의 정보를 사용한다.

- SAmple and aggregaTE를 결합해 네이밍 한 네트워크인 만큼 이웃 노드를 샘플링하고, aggregating하는 것이 이 네트워크의 핵심이다.

3. Forward Propagation (Embedding Generation Algorithm)

- [1] 첫 번째 레이어 (h0)의 입력으로는 모든 노드 v의 feature가 들어가게 된다.

- [2 - 6] 그 다음 레이어부터는 모든 노드 v에 대하여 주변 노드의 정보를 AGGREGATE하고 (이것은 이웃들에 대한 정보) 나 자신의 정보를 CONCAT한 후에 weight matrix를 곱해준다. 그리고 이 결과를 non-linear function에 입력하여 나온 출력이 해당 노드의 feature로 업데이트 해준다.

- [7] 7번째 줄에 있는 것은 normalize 내용인 것 같다.

'Data Science > ML & DL' 카테고리의 다른 글

| [graph] 그래프 임베딩에 대한 기록 (2) (0) | 2021.01.06 |

|---|---|

| [graph] 그래프 임베딩에 대한 기록 (1) (0) | 2021.01.06 |

| [graph] graph pooling에 대한 기록 (0) | 2021.01.01 |

| [graph] GNN의 set aggregator에 대한 기록 (0) | 2021.01.01 |

| [graph] 그래프의 다양한 local overlap index 정리 (0) | 2020.12.30 |

Comments